-

请先记住这个词:Moe模型。因为这个词未来会改变AI圈、改变金融圈、改变英伟达、甚至改变中美AI走向。

故事起因是这样的:

10天前,大家都准备回家过年了,结果来自浙江的一家小公司DeepSeek(深度求索)火了,它发布的V3模型,震惊了美国AI圈和金融圈,还上了新闻联播,一夜之间和华为、阿里比肩齐名了,搞的扎克伯格一度呼吁美国加紧封锁中国AI技术。

这么大事,你让别的AI公司怎么办?火车票都买好了,结果又来加班,好在阿里云是反应最快的那个,他们的算法专家立刻找到问题关键点:

DeepSeek用的是Moe模型,阿里的Qwen用的还是Moe模型。

在Moe架构领域,Qwen是规模最大的那一个,又有20万亿Tokens(相当于1.5亿本小说)。为什么DeepSeek能火爆全网、气死扎克伯格,而Qwen不能?于是阿里的工程师加班加点,甚至把车票都退了,终于在大年初一,发布了新的模型Qwen2.5-Max。注意是:Max版,就和手机一样,就是顶配版的意思。

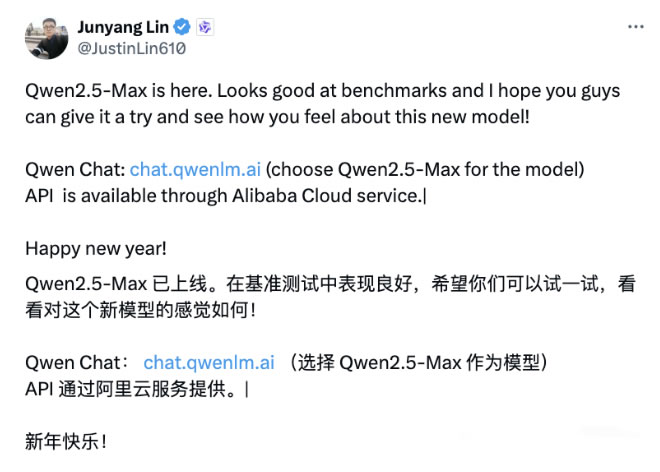

Qwen2.5-Max一发布,高级算法专家林俊旸就发了个圈:

Qwen2.5-Max这个版本最牛逼的2点是:

(1)超大规模的MoE模型,预训练数据超20万亿Tokens。

(2)全面超越DeepSeek V3

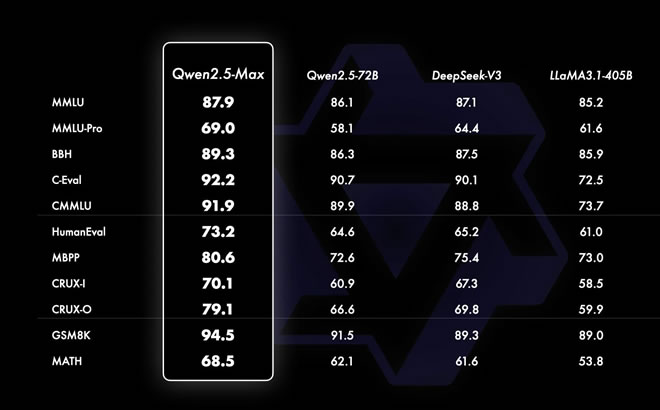

简单的说,就是性能更牛了,但更节约算力了。

如上图所示,Qwen2.5-Max的各项指标都略高于DeepSeek和LLaMA模型。

在告诉大家一个冷知识:阿里的千问、DeepSeek(深度求索)、Meta的LLaMA的底座都是MoE模型。

说了半天,估计好多人不知道什么是Moe模型吧?

简单点说:Moe模型(混合专家模型)是AI圈热门的大模型架构,它只需要激活必要的参数来处理输入的数据,减少主动计算需求的同时,使得计算成本得以大幅降低,推理性能也有所改善。不会相应增加训练和运行模型所需的计算负担,所以能同步降低训练成本。

这个架构最牛逼之处,就是主动减少计算需求,主动计算需求减少,自然节约算力,算力节约了就能节约芯片数量。这就是为什么DeepSeek能用Meta公司1/10的价格,训练出跟LLaMA模型差不多的大模型的原因。

这也是为什么扎克伯格气的牙痒痒的原因:我花了1000亿美刀做出的开源LLaMA模型,你小子花550万就做出来了。你说能不急吗?预计用不了多久,扎克伯格也会学习Deepseek的方法。等Meta 公司的 LLaMA 模型学习差不多了,估计就没Deepseek什么事了。

所以阿里的Qwen赶在Meta之前,发布全新Qwen2.5-Max版本,性能超越了Deepseek,更牛了,也更节约算力了。这样一来,以后大家对算力的要求降低了太多了,以后也不需要那么多芯片了,更没人大量屯芯片了。那以后谁还买英伟达的芯片啊?

以前所有的公司都认为AI大模型需要大力出奇迹,需要对算力进行大量的投资,要购买大量芯片,可现在一切即将改变,这是今年AI一个重要转折点,阿里起了个头,预计会有更多公司都会朝这个方向努力:节约算力,提升性能。但这样,英伟达的黄仁勋就要哭啦。

写在最后:

今年的阿里云要起飞了,先是登陆了央视春晚,大年初一又发了新的模型。阿里新发布的Qwen2.5-Max这个版本的起了个头,目测这一模型会引领新的AI方式。

如果说DeepSeek的低成本戳破美国AI的资本泡沫游戏,那么阿里云的Qwen则让AI回归科研本身,打破美国的模型壁垒,让全世界都可以参与AI研发中来了。

顶: 0 踩: 0相关阅读:

来源:卢松松博客 QQ/微信:13340454

全面超越Deepseek,阿里大年初一放大招

| 阅读量 | 分类: 微新闻 | 作者: 卢松松

相关文章阅读更多:阿里云 人工智能AI

- 2026-03-04 千问暴涨940%后突然换帅:AI上半场结束了

- 2026-03-02 90%的AI中间商会消失:Google封号只是第一枪

- 2026-02-17 AI暴利时代结束了:阿里千问把价格砍到1/18,很多公司要出局了

- 2026-01-27 DeepSeek半夜更新OCR2,用的却是阿里的Qwen

- 2025-12-26 阿里云为什么要为一篇自媒体文章下场辟谣?

- 2025-11-15 阿里和百度突然改名:AI不炫技,开始抢用户了!

- 2025-09-26 那个坐在马云身边的白衣少年,扛起了阿里云的未来

- 2025-06-07 阿里云核心域名被劫持,幕后黑手是谁?

- 2025-04-29 阿里云赌对了!Qwen3成全球最强开源AI

- 2025-04-11 退休6年的马云,突然回来了

- 2025-02-21 靠这四招,阿里利润暴涨333%!一年狂赚464亿!

- 2025-01-08 万万没想到,AI取代的第一个岗位竟是它?

- 2024-10-31 他被抓了,还了阿里云公道,顺便介绍踩缝纫机生活

- 2024-10-17 这才是阿里云注销测绘资质的原因,根本不是非法测绘

- 2021-09-08凡是在卢松松博客投稿的作者都有机会得到IT类图书哦!

发表感想加入微信群

大鱼笔记

cad视频教程

免费自学教程

百度指数提升

大军自由赚

会议设备

测厚仪

会议设备

2026年元旦