-

01

误解一:「ChatGPT 中文表现不如英文,因为简中网络封闭/贫乏/语料太烂了。

我知道很多人喜欢这个论述,是因为可以借机吐槽简中网络的内容质量。但不管这个前提对不对,大语言模型的中枢并不是中文一套,英文一套,波兰文一套,韩文一套,孟加拉文一套分别独立的(它目前支持95种语言,要训练95个独立的大脑要花多少钱?)它都用英文学过一遍相对论了,再用中文的相对论教材重新理解一遍相对论毫无意义。当然,如果你想「只」用简体中文语料训练出一个又红又专的洁版 GPT,那语料质量就会是一个真实的限制。

但这个误解其实是基于下面这个更常见也更本质的误解:

误解二:「ChatGPT 是统计模型,所以它的一切认知都是来自于它的语料。

大多数人对大神经网络的理解可能还停留在它只能抓住语料数据中的统计相关性的这个层面。但过去两年来大语言模型之所以突飞猛进,正是因为它突破了这个障碍。它确实仍然不能很好地进行逻辑推演,但人们发现统计推断/逻辑符号推断并不是非黑即白的分野,而今天的大语言模型正好落在中间的某个神秘地带上。

事实上,如果你对 ChatGPT 的使用稍微深入一点,你一定自己也能意识到「它的认知都是通过语料里反复读过才习得的」这件事不可能是真的。比如说你可以要求跟它玩游戏,游戏规则是你告诉它的,然后它就能跟你玩得有来有回。这显然不能用传统的「一切都从语料的统计里学习」的老观念来理解。一个更极端的例子是两个月前有人通过语言指示在 ChatGPT 界面下实现了一个虚拟机

这种临场学习的能力叫 in-context learning,是过去一年最热门的学术话题,而且学界本身对这个现象也还没有充分理解(就是目前处于它做到了但我们并不确切知道它为什么能做到的状态)。如果你感兴趣,这两篇最新的文献值得一读,一篇来自 Google 一篇来自微软。

02

误解三:「ChatGPT 解决不了来源准确性和新闻即时性的问题,这是大语言模型的硬伤。

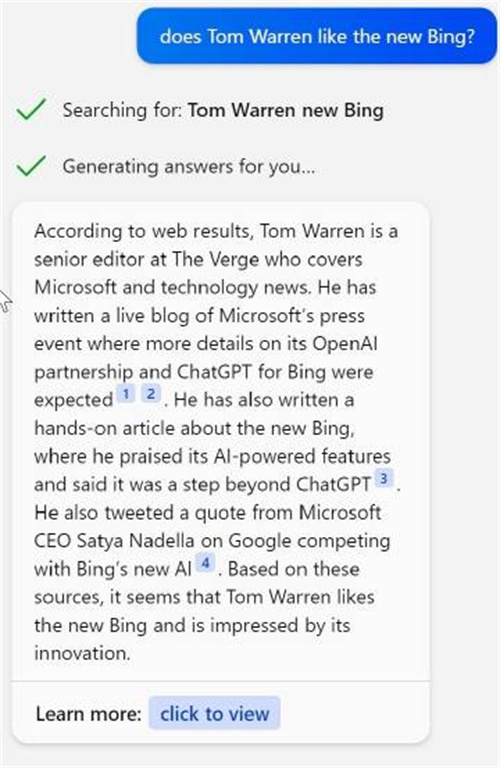

大语言模型本身如何保证「正确」是一个复杂的问题。但在普通人的应用角度,这件事可以非常轻易地从工程上绕过去。今天 Bing 的试用已经逐步铺开了(见附图),附图里是关于2023年的时事的提问(而众所周知 ChatGPT 的训练语料完全来自2021年之前),你会看到它的回答非常准确,而且每句话都附上了来源链接。这是因为 ChatGPT 或类似的大语言模型并不应该被理解为一个从零开始的静态知识库,而是一个可以动态附着在其他信息源上的 layer(「作为一种服务的自然语言界面」)。因此,哪怕用最笨的方式,搜索引擎至少可以当场把传统的搜索结果喂给它,它再以一种对话的方式把它呈现出来,而这就间接解决了准确性和即时性的问题(至少不差于传统搜索引擎)。

关于这一点我推荐一下 Verge 对微软董事长 Nadella 的采访

信息量很大,而关于搜索结果这部分他说得也非常直白:所谓结合了 AI 的搜索引擎,其实就是把传统搜索结果让 AI 以更对用户友好的方式表达出来而已。(这很重要,并不只是一个 UI 的问题,这牵涉到新的搜索时代商业框架怎么建立,利益怎么分配,流量怎么引导。

关键在于: Nadella 等于是承诺了虽然回答是 AI 给的,但源头的链接还是保留,源头网页的广告主不要慌。

03

很多这类误解归根结底是因为把 ChatGPT 这个过于成功的 demo 误当成了一个成熟产品,然后又把对它的印象推广到了大语言模型整体。但 ChatGPT 的推出有很大意外成分,它不是一个被精心产品化的产物,它的很多缺失只不过是因为 OpenAI 没人也没时间去做,实现这些功能也不是 OpenAI 的长处,是微软该做的事。

我的猜测是,等新的 Bing 和正在疯狂测试的 Bard 全面上线,目前这个版本的 ChatGPT 很快就会被大众遗忘了。 归根结底,ChatGPT 在计划中只是前菜,今年的主菜是GPT 4。

作者:木遥的微博

顶: 2 踩: 0相关阅读:

来源:卢松松博客 QQ/微信:13340454

解释一些关于大语言模型的常见误解

| 阅读量 | 分类: 好文分享 | 作者: 转载大师

相关文章阅读更多:ChatGPT 人工智能AI

- 2025-08-08 GPT-5有多强?4个缺点+5个优点全在这了

- 2025-06-18 我用ChatGPT帮我竞标,我感觉我快下岗了

- 2025-06-11 算力翻倍、股价起飞,AI时代的财富大迁徙已开始!

- 2025-05-16 AI 重新定义了短视频、直播间甚至人类吗

- 2024-11-26 AI带来的赚钱机会,以及利用AI工具提升数倍工作效率

- 2024-09-03 谈一点关于我对AI绘画的想法

- 2024-06-25 OpenAI痛下杀手:国内将不能用OpenAI API了

- 2024-06-11 万众瞩目的苹果AI来了,但我们用不了

- 2024-05-29 普通人用ChatGPT是违法的

- 2024-04-30 一个AI课给我打开了新世界的大门

- 2024-04-26 2024年,就是AI互联网的时代开启

- 2024-04-02 今天起,ChatGPT无需注册就能用了!

- 2024-02-20 第一批靠Sora赚钱的人已经出现了

- 2024-02-16 OpenAI发布文生视频大模型Sora

- 2021-09-08凡是在卢松松博客投稿的作者都有机会得到IT类图书哦!

发表感想加入微信群

网页模板下载

ty

福钱网

抖音评论获客

企业盘

ys31.com